Создание Robots.txt для сайта

Автор: Westblogger, 2011 год. 155 Я думаю любой вебмастер стремится к тому, чтобы поисковые системы индексировали только те странички, которые хотите вы. Но вот незадача, у сайта, кроме полезной части, которая предназначена только для посетителей, могут быть и другие части, такие как например админка, которые индексировать совершенно не нужно. Чтобы запретить поисковым паукам лазить по лишним страничкам или разделам, вам поможет создание Robots.txt для сайта.

Я думаю любой вебмастер стремится к тому, чтобы поисковые системы индексировали только те странички, которые хотите вы. Но вот незадача, у сайта, кроме полезной части, которая предназначена только для посетителей, могут быть и другие части, такие как например админка, которые индексировать совершенно не нужно. Чтобы запретить поисковым паукам лазить по лишним страничкам или разделам, вам поможет создание Robots.txt для сайта.

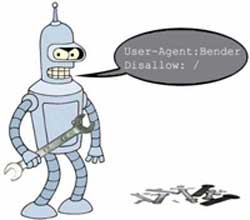

Итак, как вы могли понять, в этой статье речь пойдет о закрытии к индексированию нежелательных частей сайта с помощью файла Robots.txt Для начала несколько ссылок, которые помогут понять, как работать с этим текстовым файликом, лежащим в корне сайта:

1) help.yandex.ru/webmaster/?id=996567 – статья про Robots от Яндекса. Конечно есть много левой информации, которая вам возможно и не пригодится никогда, но тем не менее.

2) robotstxt.org.ru – уже более доступно, информация охватывает все поисковики.

3) google.com/support/webmasters/bin/answer.py?hl=ru&answer=156449&from=35237&rd=1 – рекомендации по созданию Robots.txt для Google

После прочтения этих статей, руководствуясь простыми рекомендация и операторами (такими как User-agent и dissallow) вы сможете закрыть практически все нежелательные части сайта. Также, вас может заинтересовать и еще более простой подход к созданию Robots.txt и карты сайта Sitemap, о этом я уже писал статью, с которой также рекомендую познакомится.

После прочтения данной статьи различного рода директивы для роботс.тхт не будут выглядеть как иероглифы фен-шуй.